Tecnologia Científica

Ensinar robôs a mapear grandes ambientes

Uma nova abordagem desenvolvida no MIT pode ajudar um robô de busca e resgate a navegar em um ambiente imprevisível, gerando rapidamente um mapa preciso de seus arredores.

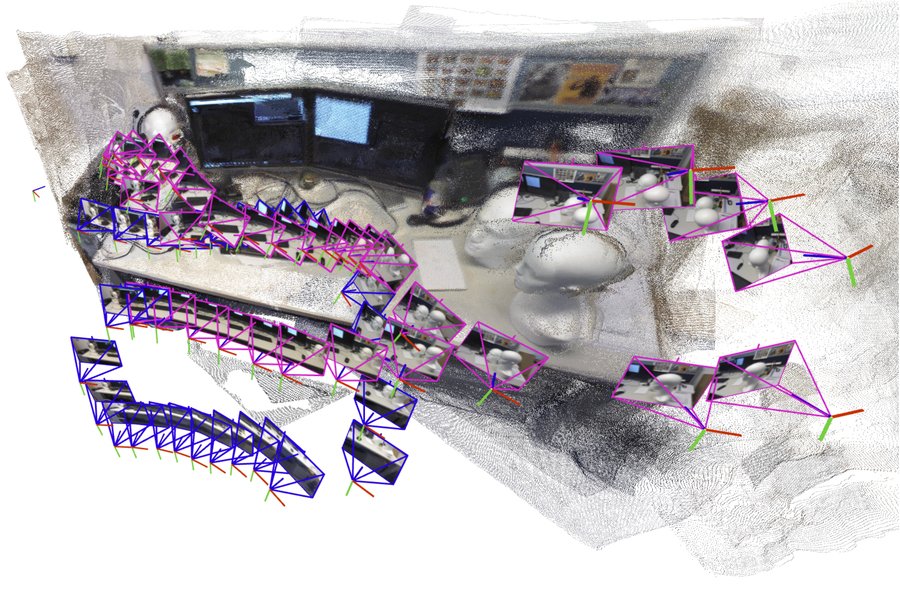

O sistema, baseado em inteligência artificial, cria e alinha incrementalmente submapas menores da cena, que são então unidos para reconstruir um mapa 3D completo, como o de um cubículo de escritório, enquanto estima a posição do robô em tempo real. Crédito: Cortesia dos pesquisadores

Um robô que busca trabalhadores presos em um poço de mina parcialmente desabado precisa gerar rapidamente um mapa da cena e identificar sua localização dentro desse mapa enquanto navega pelo terreno traiçoeiro.

Recentemente, pesquisadores começaram a desenvolver modelos de aprendizado de máquina poderosos para realizar essa tarefa complexa usando apenas imagens das câmeras integradas do robô, mas mesmo os melhores modelos só conseguem processar algumas imagens por vez. Em um desastre real, onde cada segundo conta, um robô de busca e resgate precisaria percorrer rapidamente grandes áreas e processar milhares de imagens para concluir sua missão.

Para superar esse problema, pesquisadores do MIT se basearam em ideias de modelos recentes de visão computacional de inteligência artificial e de visão computacional clássica para desenvolver um novo sistema capaz de processar um número arbitrário de imagens. Seu sistema gera com precisão mapas 3D de cenas complexas, como um corredor de escritório lotado, em questão de segundos.

O sistema baseado em IA cria e alinha incrementalmente submapas menores da cena, que são então unidos para reconstruir um mapa 3D completo, enquanto estima a posição do robô em tempo real.

Ao contrário de muitas outras abordagens, a técnica deles não exige câmeras calibradas nem um especialista para ajustar uma implementação de sistema complexa. A simplicidade do método, aliada à velocidade e à qualidade das reconstruções 3D, facilitaria sua ampliação para aplicações no mundo real.

Além de auxiliar robôs de busca e resgate na navegação, esse método poderia ser usado para criar aplicações de realidade aumentada para dispositivos vestíveis, como headsets de realidade virtual, ou permitir que robôs industriais encontrem e movimentem mercadorias rapidamente dentro de um armazém.

“Para que os robôs realizem tarefas cada vez mais complexas, eles precisam de representações cartográficas muito mais complexas do mundo ao seu redor. Mas, ao mesmo tempo, não queremos dificultar a implementação desses mapas na prática. Mostramos que é possível gerar uma reconstrução 3D precisa em questão de segundos com uma ferramenta pronta para uso”, afirma Dominic Maggio, estudante de pós-graduação do MIT e autor principal de um artigo sobre esse método .

Maggio é acompanhado no artigo pelo pós-doutorando Hyungtae Lim e pelo autor sênior Luca Carlone, professor associado do Departamento de Aeronáutica e Astronáutica (AeroAstro) do MIT, investigador principal do Laboratório de Sistemas de Informação e Decisão (LIDS) e diretor do Laboratório MIT SPARK. A pesquisa será apresentada na Conferência sobre Sistemas de Processamento de Informação Neural.

Elaborando um plano de solução

Durante anos, os pesquisadores têm se dedicado a compreender um elemento essencial da navegação robótica chamado localização e mapeamento simultâneos (SLAM). No SLAM, um robô recria um mapa do seu ambiente enquanto se orienta no espaço.

Os métodos tradicionais de otimização para essa tarefa tendem a falhar em cenários complexos ou exigem a calibração prévia das câmeras integradas ao robô. Para evitar esses problemas, os pesquisadores treinam modelos de aprendizado de máquina para que aprendam essa tarefa a partir de dados.

Embora sejam mais simples de implementar, mesmo os melhores modelos conseguem processar apenas cerca de 60 imagens de câmera por vez, o que os torna inviáveis para aplicações em que um robô precisa se mover rapidamente por um ambiente variado enquanto processa milhares de imagens.

Para resolver esse problema, os pesquisadores do MIT desenvolveram um sistema que gera submapas menores da cena em vez do mapa completo. O método "cola" esses submapas em uma reconstrução 3D completa. O modelo ainda processa apenas algumas imagens por vez, mas o sistema consegue recriar cenas maiores muito mais rapidamente, unindo os submapas menores.

“Parecia uma solução muito simples, mas quando a experimentei pela primeira vez, fiquei surpreso ao constatar que não funcionou tão bem”, diz Maggio.

Em busca de uma explicação, ele mergulhou em artigos de pesquisa sobre visão computacional das décadas de 1980 e 1990. Através dessa análise, Maggio percebeu que erros na forma como os modelos de aprendizado de máquina processavam imagens tornavam o alinhamento de submapas um problema mais complexo.

Os métodos tradicionais alinham submapas aplicando rotações e translações até que se alinhem. Mas esses novos modelos podem introduzir alguma ambiguidade nos submapas, o que dificulta o alinhamento. Por exemplo, um submapa 3D de um lado de uma sala pode ter paredes ligeiramente curvadas ou esticadas. Simplesmente rotacionar e transladar esses submapas deformados para alinhá-los não funciona.

“Precisamos garantir que todos os submapas sejam deformados de maneira consistente para que possamos alinhá-los bem uns com os outros”, explica Carlone.

Uma abordagem mais flexível

Utilizando ideias da visão computacional clássica, os pesquisadores desenvolveram uma técnica matemática mais flexível que pode representar todas as deformações nesses submapas. Ao aplicar transformações matemáticas a cada submapa, esse método mais flexível consegue alinhá-los de forma a solucionar a ambiguidade.

Com base nas imagens de entrada, o sistema gera uma reconstrução 3D da cena e estimativas das localizações das câmeras, que o robô usaria para se localizar no espaço.

“Assim que Dominic teve a intuição de conectar esses dois mundos — abordagens baseadas em aprendizado e métodos tradicionais de otimização — a implementação foi bastante direta”, diz Carlone. “Criar algo tão eficaz e simples tem potencial para muitas aplicações.”

O sistema desenvolvido por eles apresentou desempenho mais rápido e com menor erro de reconstrução do que outros métodos, sem a necessidade de câmeras especiais ou ferramentas adicionais para processamento de dados. Os pesquisadores geraram reconstruções 3D quase em tempo real de cenas complexas, como o interior da Capela do MIT, utilizando apenas vídeos curtos capturados com um celular.

O erro médio nessas reconstruções 3D foi inferior a 5 centímetros.

No futuro, os pesquisadores querem tornar seu método mais confiável para cenas especialmente complexas e trabalhar para implementá-lo em robôs reais em ambientes desafiadores.

“Conhecer a geometria tradicional compensa. Se você entender profundamente o que está acontecendo no modelo, poderá obter resultados muito melhores e tornar as coisas muito mais escaláveis”, diz Carlone.

Este trabalho foi financiado, em parte, pela Fundação Nacional de Ciência dos EUA, pelo Escritório de Pesquisa Naval dos EUA e pela Fundação Nacional de Pesquisa da Coreia. Carlone, atualmente em período sabático como pesquisador da Amazon, concluiu este trabalho antes de ingressar na Amazon.